Wirtschaft, Wissenschaft und Verwaltung, aber auch Politik und Gesellschaft nutzen zunehmend Analysen georeferenzierter Daten, um verborgene Muster in vorhandenen Informationen sichtbar zu machen, neue Erkenntnisse zu gewinnen und dem Wettbewerb einen Schritt voraus zu sein. Umfassendes Wissen über vorhandene Zustände und Werte ist eine wesentliche Grundlage für Planungs-, Neuausrichtungs- und Nutzungsprozesse.

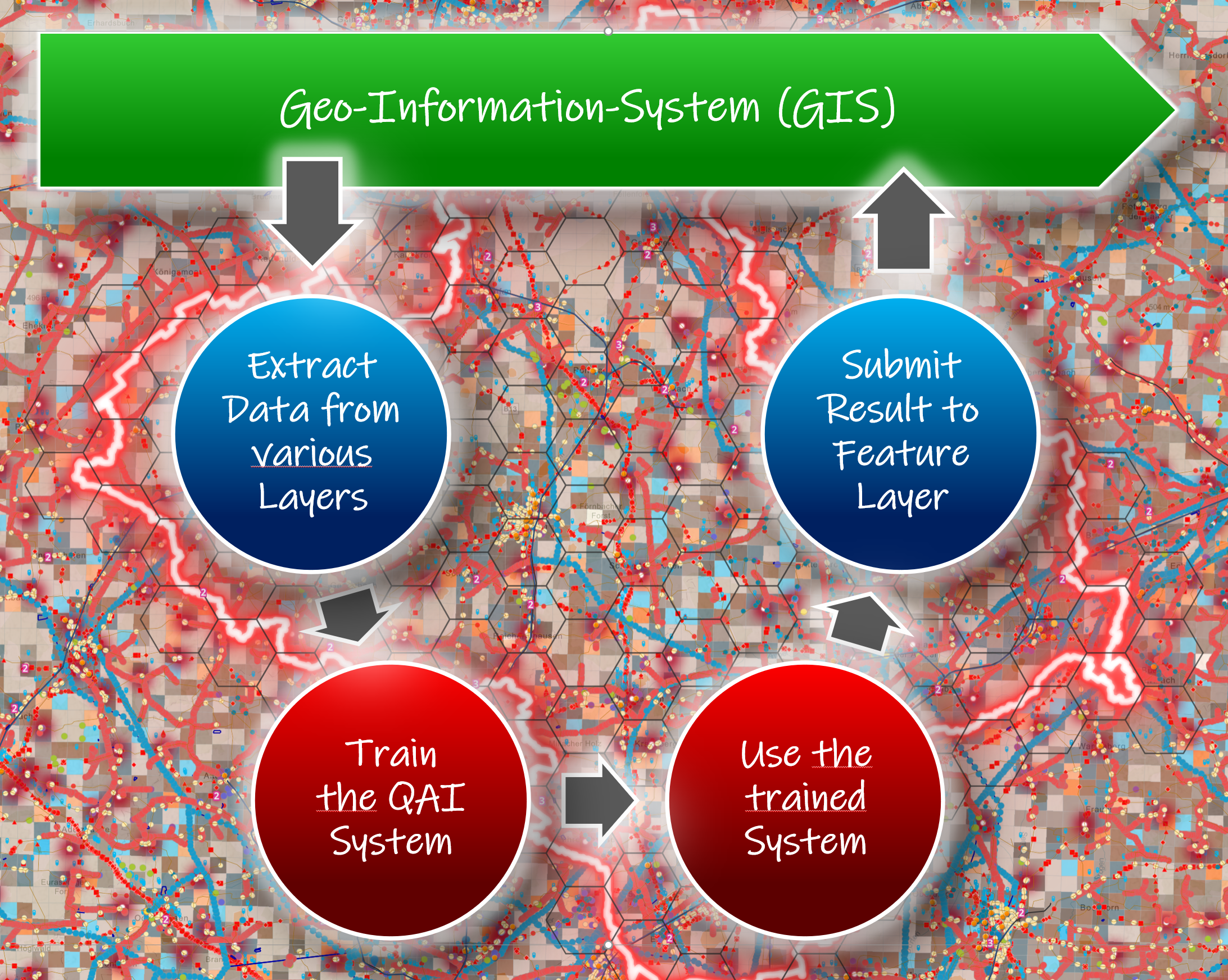

Datenlauf von QAI-Systemen bei der Geodatennutzung

Geographische Informationssysteme (GIS) verwenden den räumlich-zeitlichen Standort als zentrale Indexvariable für alle Informationen. Standorte oder Ausdehnungen in der Raumzeit können als Datum/Zeit des Auftretens und als x-, y- und z-Koordinaten aufgezeichnet werden, die die Längen- und Breitengrade bzw. die Höhenlagen darstellen. Die GIS-Koordinaten können aber auch andere quantifizierte raumzeitliche Inhalte darstellen, z. B. die Nummer eines Filmbildes, die Pegelstation eines Gewässers, eine Gebäudeadresse, eine Straßenkreuzung, ein Eingangstor, eine Wassertiefensondierung, …). Die raumzeitlichen Daten können letztlich mit einem „echten“ physischen Ort oder einer Ausdehnung in der Raumzeit in Beziehung gesetzt werden können.

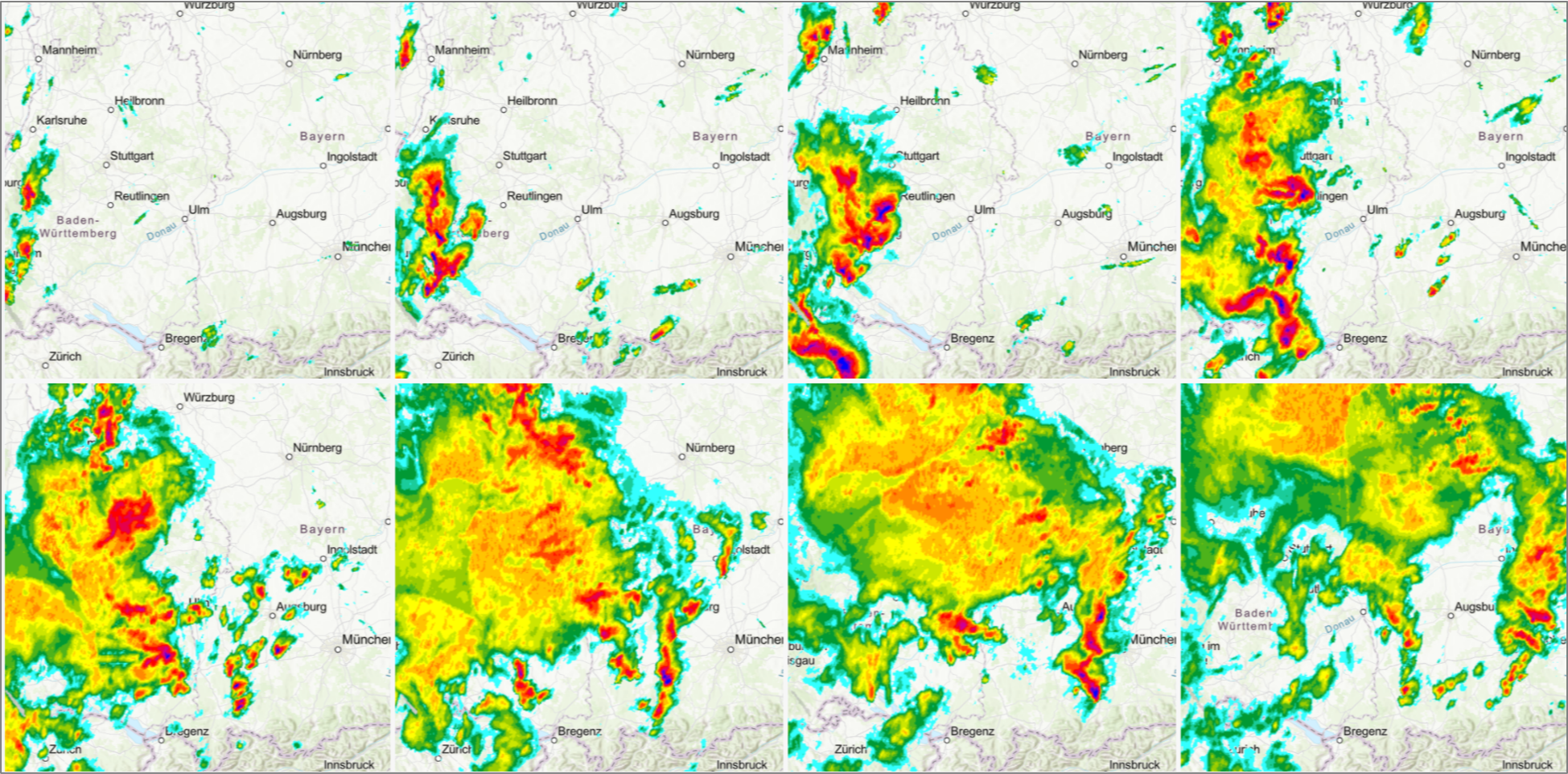

Bilder des Regenradars des Deutschen Wetterdienstes (www.dwd.de)

Die vorstehende Bilderserie zeigt raumzeitabhängige Daten Süddeutschlands, die über die Dienste des Deutschen Wetterdienstes (www.dwd.de) abgerufen werden können.

Die Auswertung der Daten (zum Beispiel des Niederschlagsradars) wird heute regelmäßig mit Werkzeugen aus dem Bereich der Künstlichen Intelligenz unterstützt.

Datenauswertung aus Bildmaterial des Deutschen Wetterdienstes (www.dwd.de)

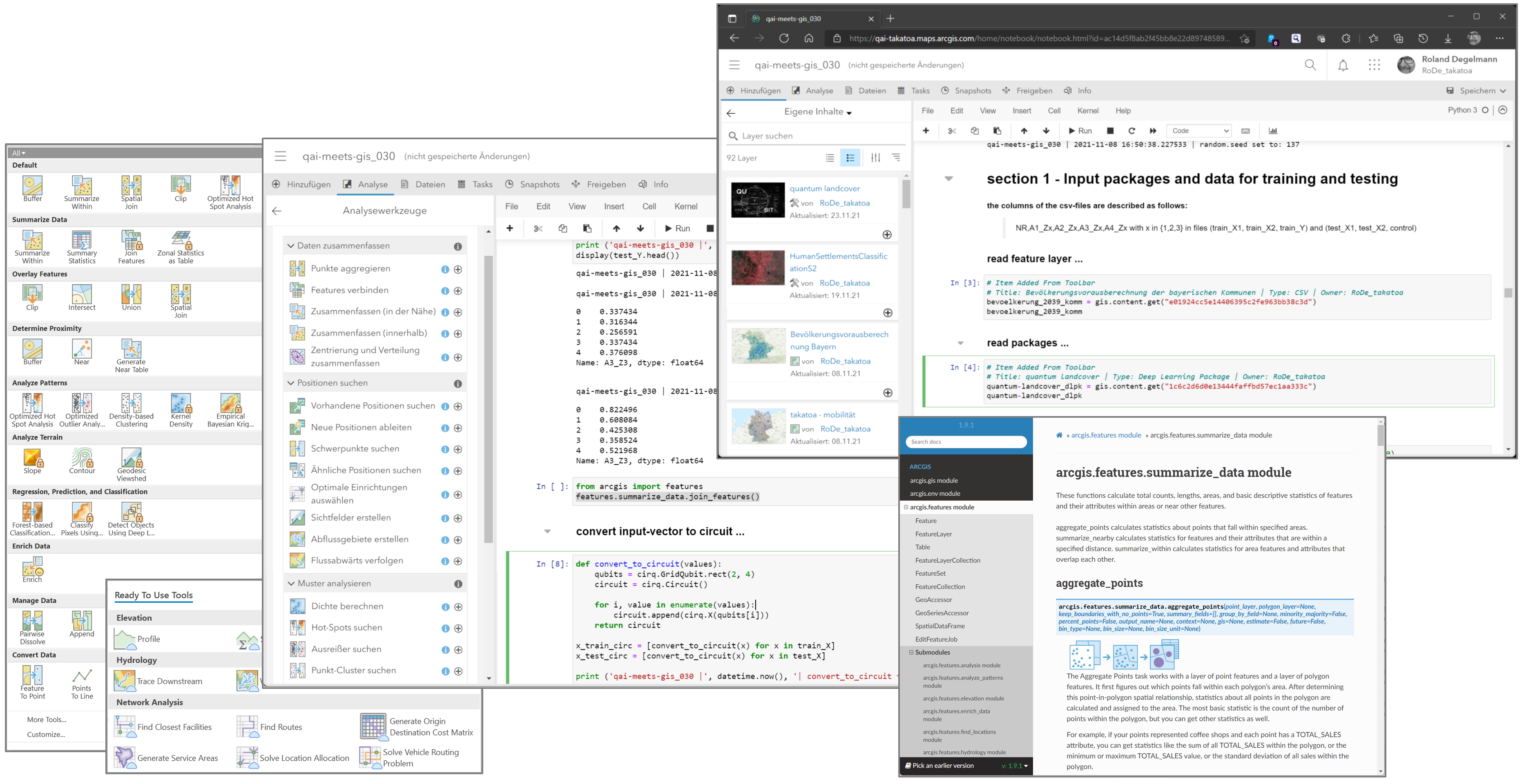

Zur Auswertung nicht nur von dynamischen Karteninhalten und zur Datenvorbereitung für Quantenberechnungen kann heute unter anderem auf ein breites Spektrum von Analyse-Werkzeugen von Esri ArcGIS zurückgegriffen.

Analysewerkzeuge aus dem Bereich Esri ArcGIS und deren Nutzung zur Datenaufbereitung über Jupyter Notebooks

Die Verarbeitung aller verfügbaren Daten erfolgt regelmäßig in leistungsfähigen Rechnersystemen; die darauf ausgeführte Software hat in den letzten Jahren enorm an Nutzungsmöglichkeiten zugenommen.

Vor diesem Hintergrund ist auch das Interesse an Künstlicher Intelligenz und die Zahl der diesbezüglichen, bahnbrechenden Anwendungen in den letzten Jahren stark gewachsen. Künstliche Intelligenz beschäftigt sich mit der Entwicklung von computerunterstützten Rechensystemen, die Probleme in Anlehnung an biologische Gehirn- und Nervenstrukturen (Neuronale Netze) abarbeiten. Standortmanagement-Analysen mit Hilfe von Künstlicher Intelligenz durchzuführen ist heute Standard.

Quantum Artificial Intelligence

Quantencomputing ist das „nächste große Ding“ in der Entwicklung der Informationstechnologie. In Kombination mit GIS-Tools wird es eine breite Palette weiterer Fortschritte in der Standortanalyse ermöglichen. Quanteninformatik wird komplexere Rechenaufgaben bewältigen und Ergebnisse liefern, die mit den leistungsstärksten klassischen Hochleistungscomputern entweder nicht oder nicht in einem vernünftigen Zeitrahmen erreicht werden können.

Im Gegensatz zur Umsetzung in klassischen Computern, bei dem Berechnungen sequentiell durchgeführt werden, nutzt das Quantencomputing die Potentiale der Quantenmechanik wie Überlagerung und Verschränkung, um enorme Kombinationen von Zuständen gleichzeitig zu betrachten und den großem Umfang von verfügbaren Informationen gemeinsam zu verarbeiten.

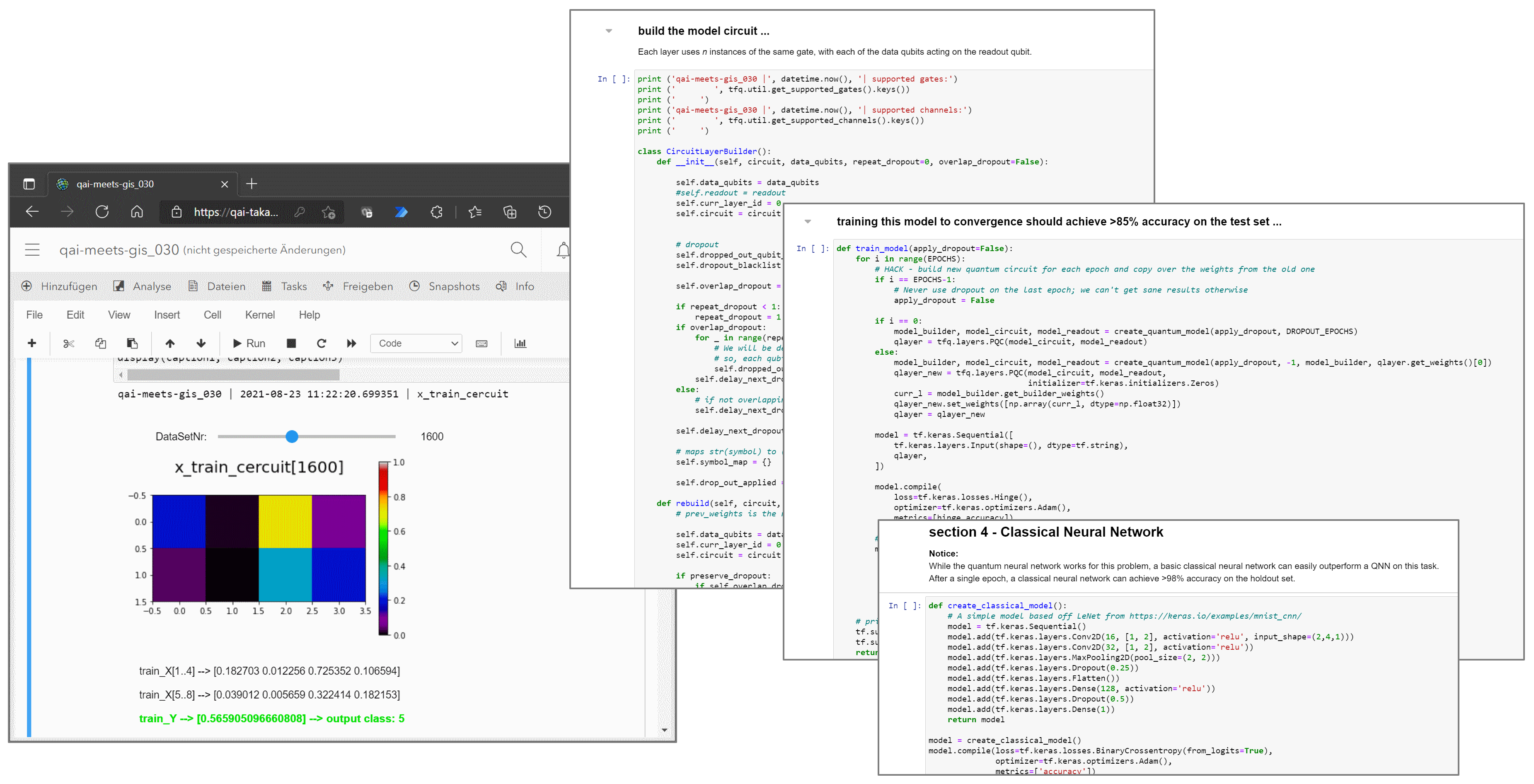

Daten-Preprocessing und Quantensystem-Vorbereitung im Jupyter Notebook

Quantumcomputing reift durch das Aufkommen leistungsfähigerer Quantenprozessoren mit einer zunehmenden Anzahl von Qubits, besseren Algorithmen und mehr Entwicklertools wie Compilern und Bibliotheken. Da eine reifende Quantentechnologie in der Lage ist, immer komplexere Anwendungen zu adressieren, wird sich die entsprechende kommerzielle Wirkung in der Zukunft massiv erhöhen. Während der genaue Zeitpunkt noch unbekannt ist, wird erwartet, dass der resultierende Geschäftswert enorm sein wird. Er wird auf Milliarden Dollar in dreistelliger Höhe geschätzt.

Die jüngsten Fortschritte bei der Entwicklung und Kommerzialisierung von Quantentechnologien haben die Landschaft der Quantenalgorithmen tiefgreifend verändert. Quantengeräte in naher Zukunft erfordern Routinen, die von geringer Tiefe und robust gegen Fehler sind. Neben anderen Bereichen, in denen Quantencomputer einen Vorteil gegenüber dem klassischen High-Performance-Computing (HPC) haben, gibt es entsprechende Potentiale vor allem auch bei der Optimierung und Beschleunigung von Berechnungen in Systemen der Künstlichen Intelligenz. Das Entwurfsparadigma hybrider Algorithmen, die Quanten- und klassische Verarbeitung integrieren, hat daher zunehmend an Bedeutung gewonnen.

Takatoa nutzt die dargestellten Entwicklungen und überträgt deren Anwendung auf das Kompetenzfeld Spatial Business Intelligence (SBI).

Auf Quantenseite wird die Nutzbarkeit verschiedener, nachgenannter Lösungsansätze untersucht:

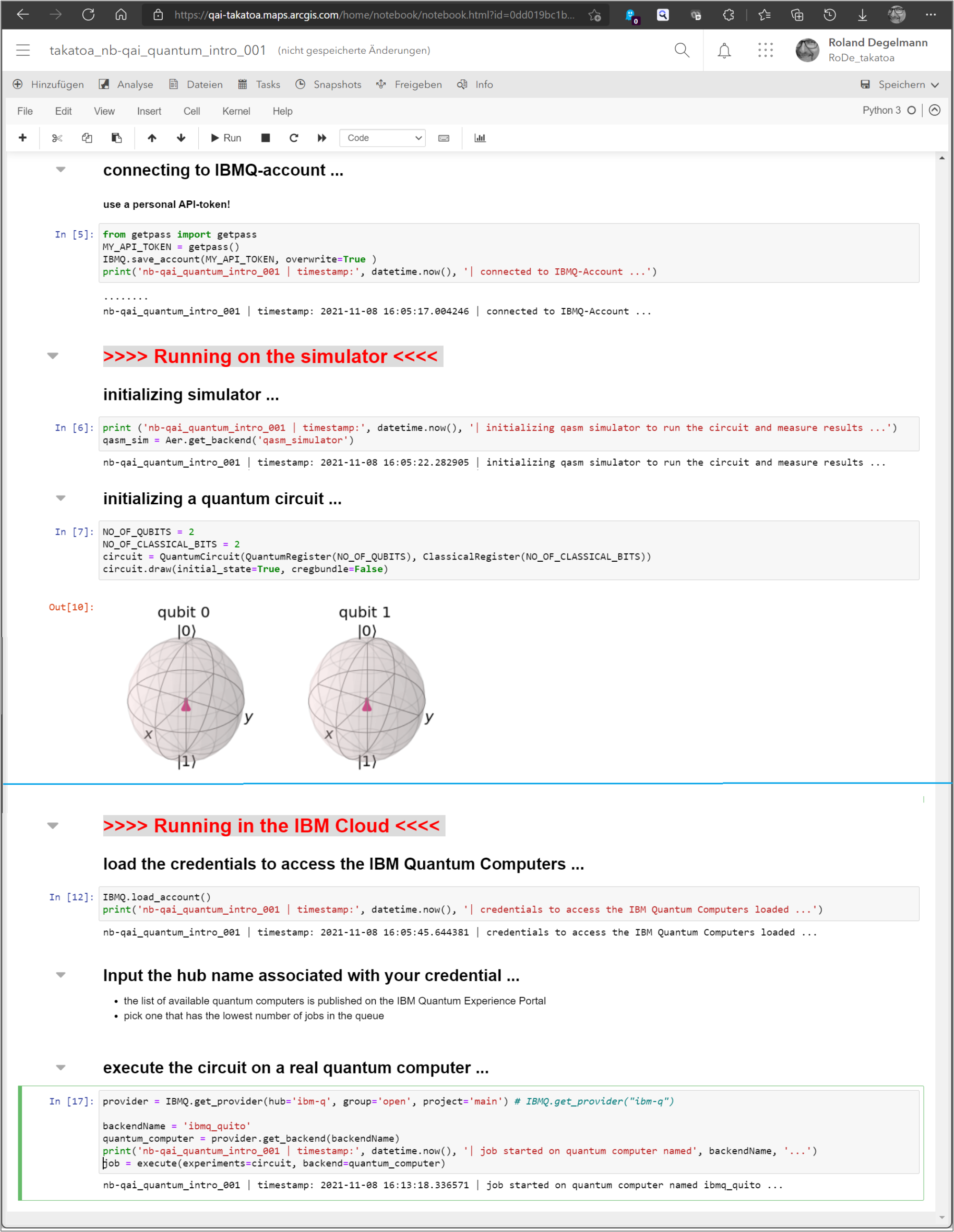

Dissipative Perceptron-Based Quantum Neural Network (DPBQNN) Quantum Long Short-term Memory (QLSTM) Quantum Multiclass Margin Classifier (QMMC) Quantum Nearest Centroid Classification (QNCC) Quantum Transfer Learning (QTL) Variational Quantum Circuits (VQC)Die Darstellung zeigt – exemplarisch für den Zugriff auf die von IBM bereitgestellten Lösungen – den Einstieg, wie die Verknüpfung mit vorhandenen Quanten-Systemen in einem Jupyter Notebook umgesetzt wird.

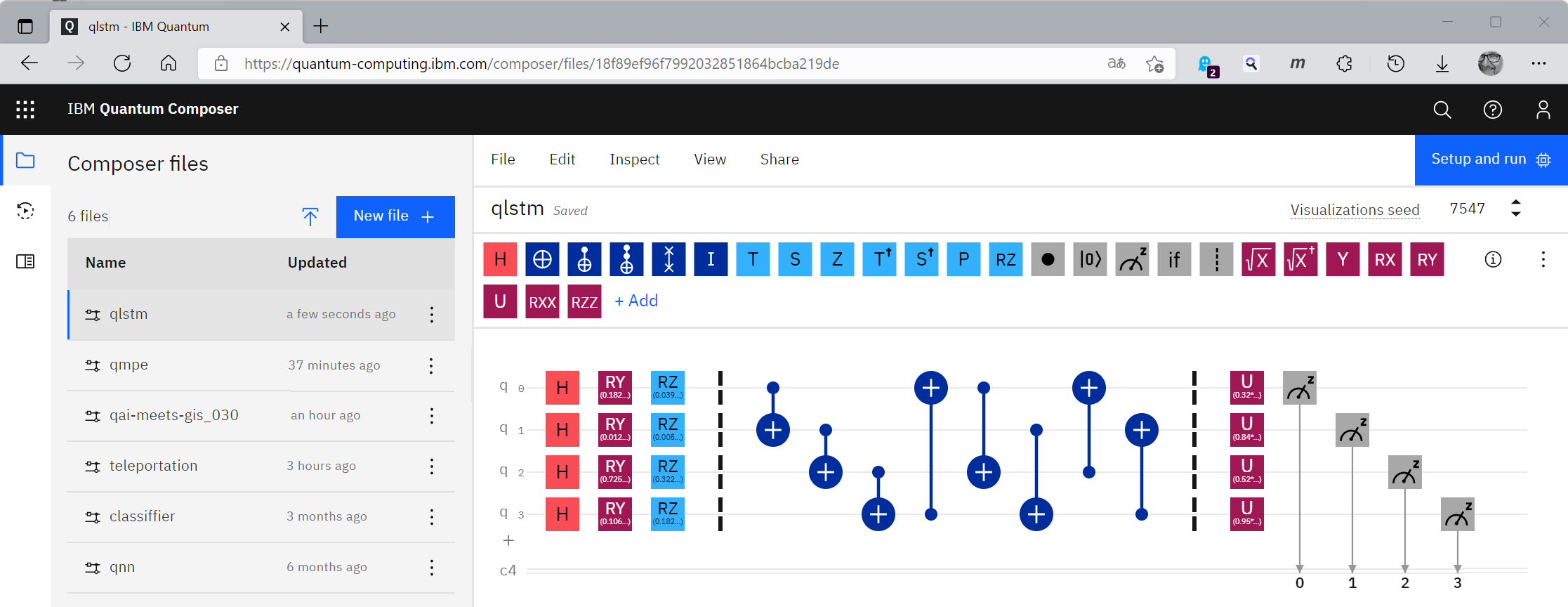

Die Umsetzung einzelner Komponeneten kann, wie nachfolgend gezeigt auch in dem unmittelbaren Quantum-Umfeld (wie hier im IBM Quantum Composer) erfolgen.

Beschreibung eines QLSTM-Ansatzes im IBM Quantum Composer

Ergebnisse und Nutzung

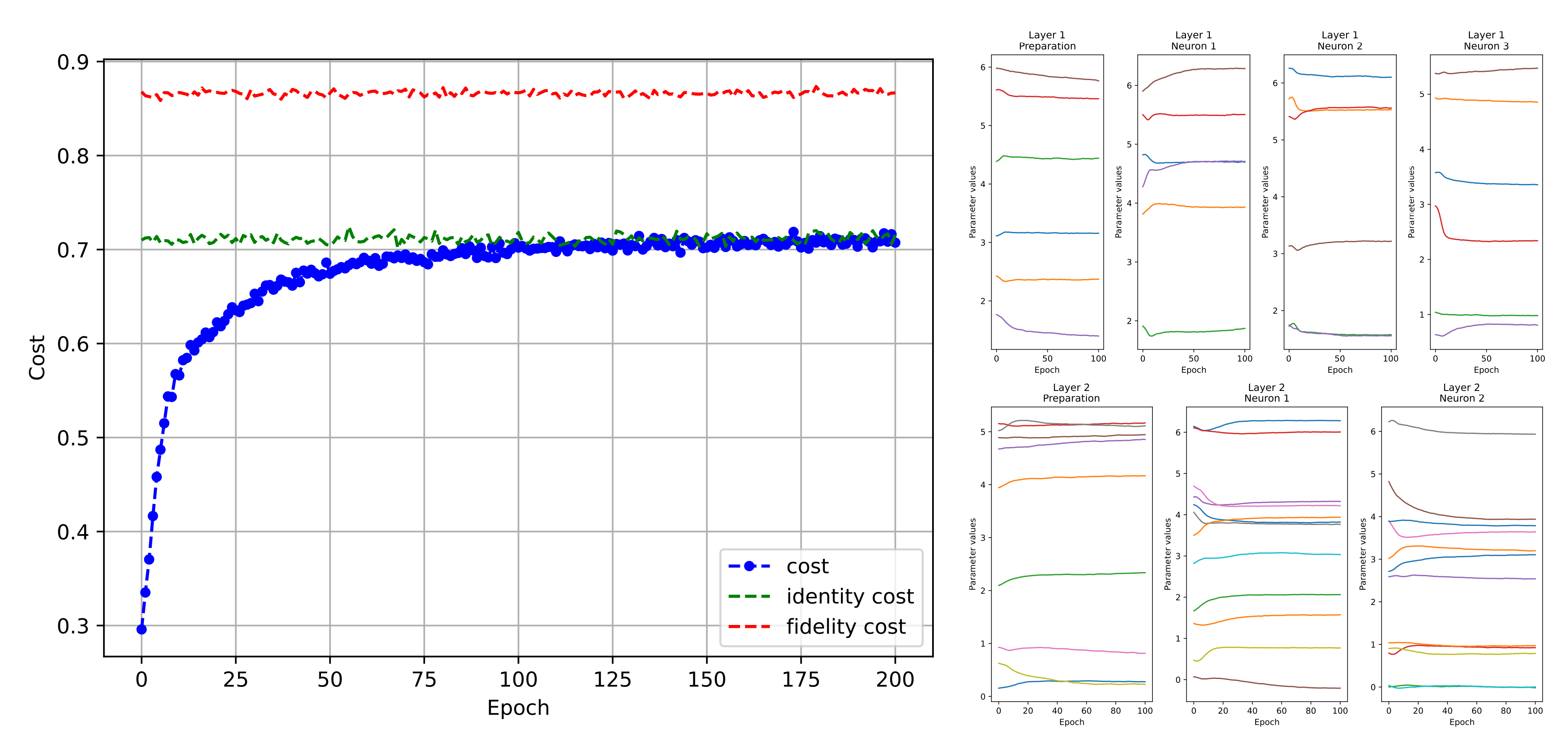

Die bisher durchgeführten Berechnungen bestätigen grundsätzlich die Nutzbarkeit der oben genannten Ansätze. Sie zeigen gute Lernfähigkeit und hohe Ergebnisstabilität, soweit diese bei der genutzten Quantum-Hardware auch bereit gestellt und genutzt werden kann.

Trainingsergebnisse von Rechenläufen mit dem zeitliche Entwicklungen von Zustandswerten prognostiert wurden (Kostenfunktion und Parameterwerte). Gerechnet wurde mit einer reduzierten Anzahl von insgesamt 3872 Trainingsdatensätzen mit jeweils acht Daten (je vier Eingangswerte für zwei Zeitpunkte t-1 und t), sowie mit jeweils einen für das Training bekannten Ergebniswert für den Zeitpunkt t+1.

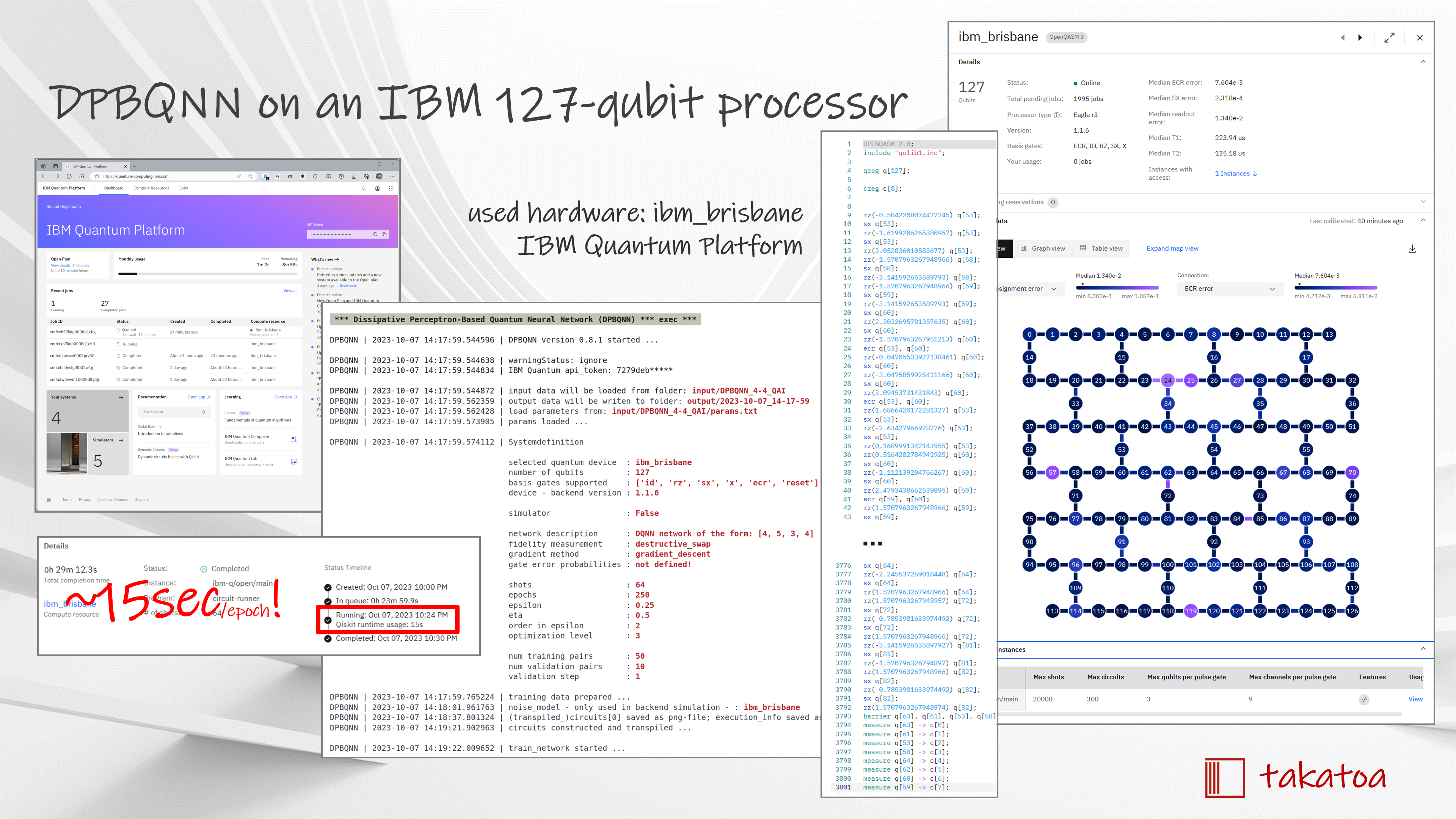

Mit der Umsetzung von „Dissipative Perceptron-based Quantum Neural Network (DPBQNN)“ auf heute verfügbare Quantum-Hardware können Zeitvorteile im Bereich der Quantum-Nutzung belegt und notwendige Verbesserungsbedarfe gezielt positioniert und angegangen werden.

Insbesondere die Lösung von grundlegenden Fragen zur Fehlerminimierung bedarf aber noch massiver Anstrengungen.

Gezeigt werden vorstehend Screenshots aus der Arbeit mit DPBQNN unter Nutzung der IBM 127-qubit Prozessors ibm_brisbane. Umgesetzt werden dabei auch Netzwerkstrukturen mit mehreren Hidden-Layern unterschiedlicher Größenordnung.

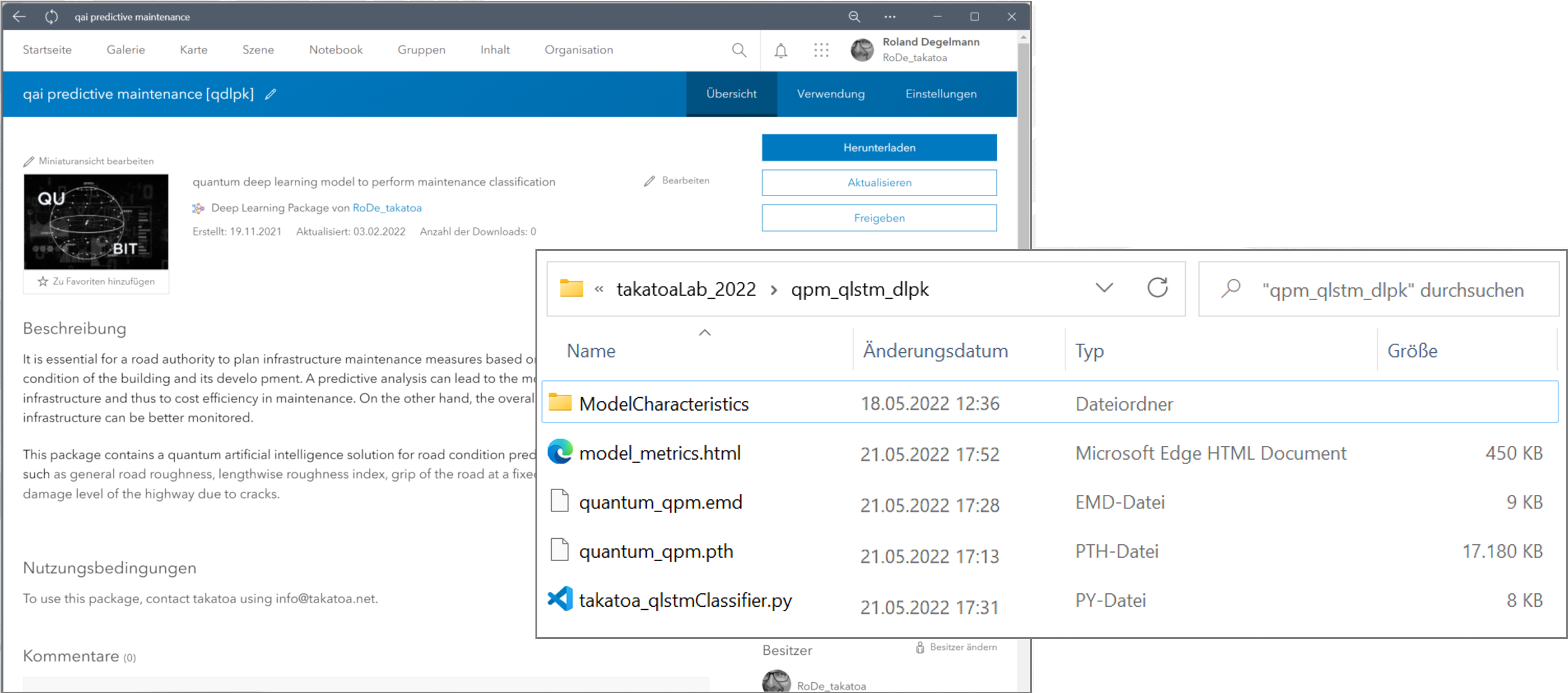

Im Esri-Umfeld können die Strukturen der erarbeiteten Modelle aus dem Bereich Quantum Artificial Intelligence als dlpk-Dateipaket bereitgestellt und dadurch auch von Dritten unmittelbar genutzt werden.

Screenshot aus ArcGIS Online zum bereitgestellten dlpk-Paket

Die Ergebnisse aus Berechnungen von Quantencomputern können in gleicher Weise wie die herkömmlicher Berechnungen als Feature-Informationen in Karten-Layer zurückgeschrieben werden und stehen dort für die graphische Aufbereitung und weitere Nutzung zur Verfügung.