Quelle: Uwe Vigenschow | dotnetpro 05/2018

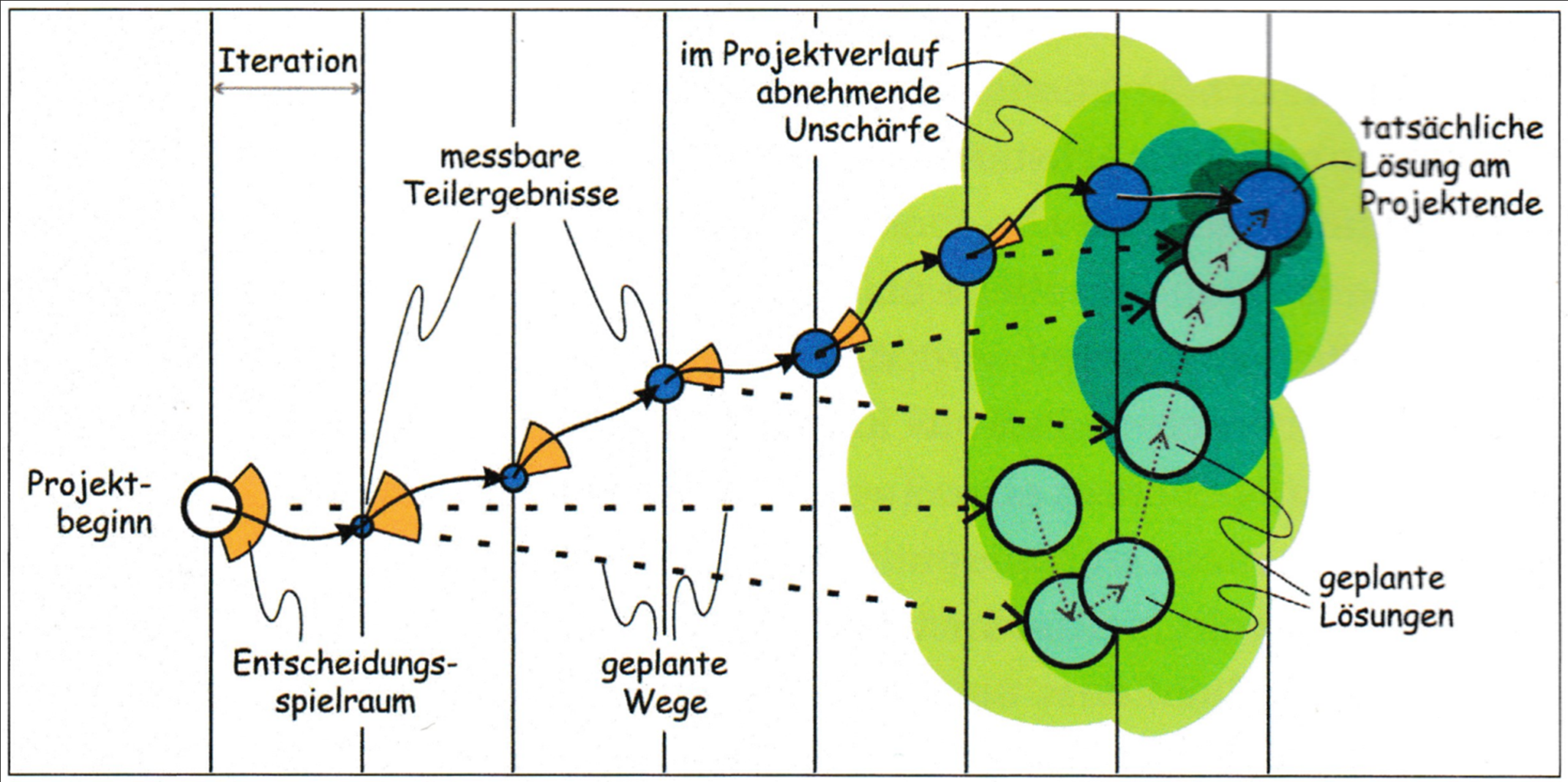

moving targets

Gleichzeitig mit der schrittweise Annäherung an die Lösung / das Ziel während des Projektverlaufs verändert sich auch die Lösung / das Ziel selbst. Der verfügbare Spielraum wird durch die vorweg getroffenen Entscheidungen zwar immer mehr reduziert. Gleichzeitig bewegt sich das Ziel selbst aber kontinuierlich weiter.

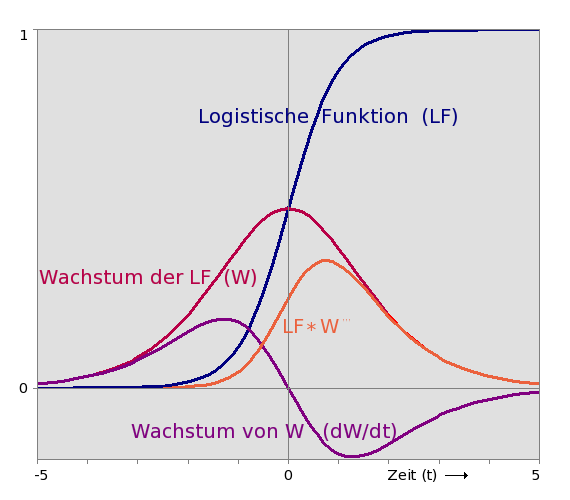

Logistische Funktion

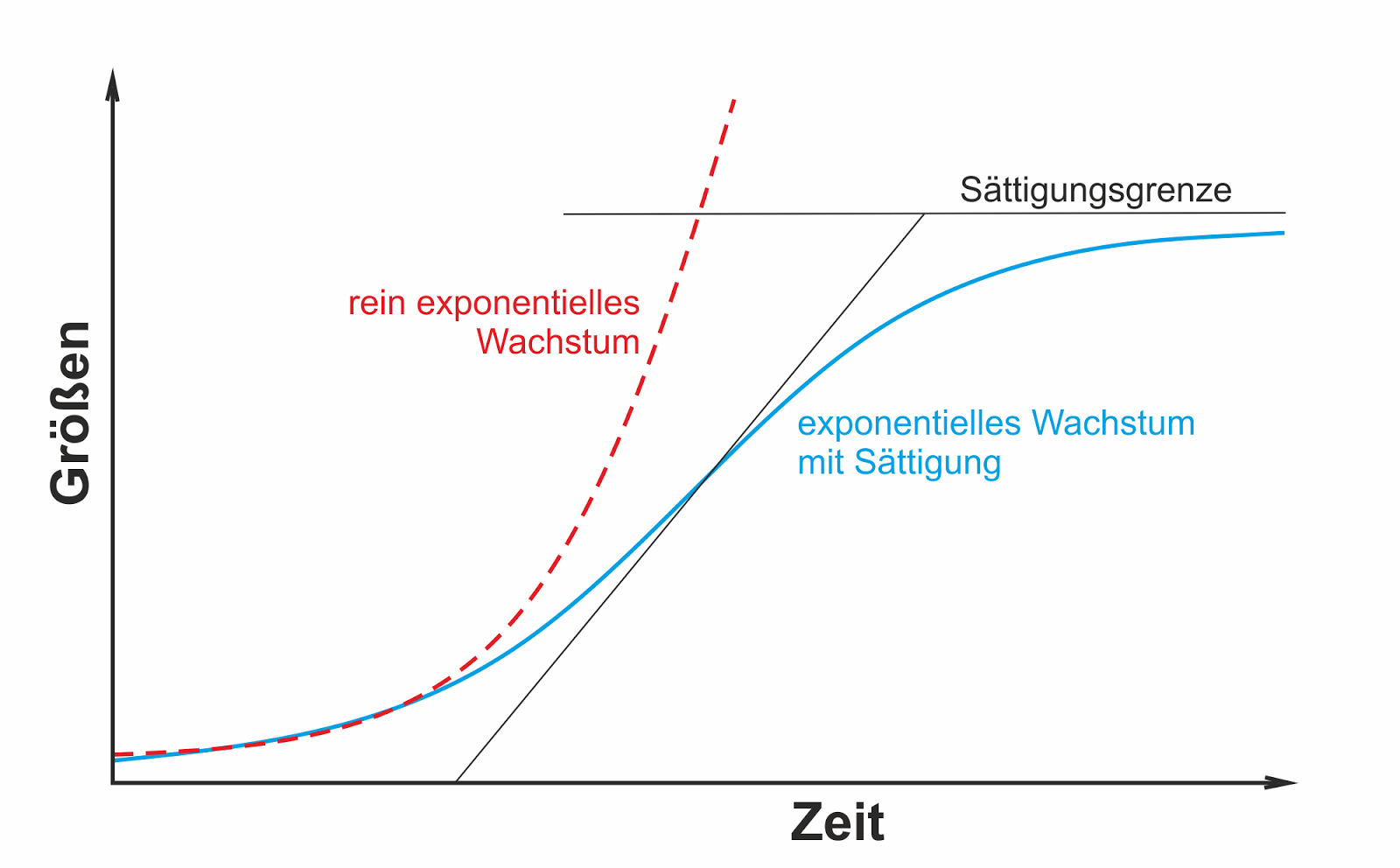

„Nichts kann in einer endlichen Welt unendlich werden.“ (Manfred Eigen)

Exponentielle Wachstumsprozesse werden immer durch Mangel begrenzt und es kommt zu nicht vorhersehbaren Diskontinuitäten. Dann geht das exponentielle Wachstum häufig in eine logistische Kurve über. Dabei ist es egal, ob es sich um das Wachstum der Weltbevölkerung, Bakterienpopulationen oder Ebola-Kranke handelt. Die logistische Kurve hat einen S-förmigen Verlauf und wird durch folgende Funktion beschrieben:

Weitere Infos

Quelle: http://anorg-chemie.blogspot.com/2016/04/

Quelle: https://deacademic.com/pictures/dewiki/76/LogistischeFunktionPlus.png

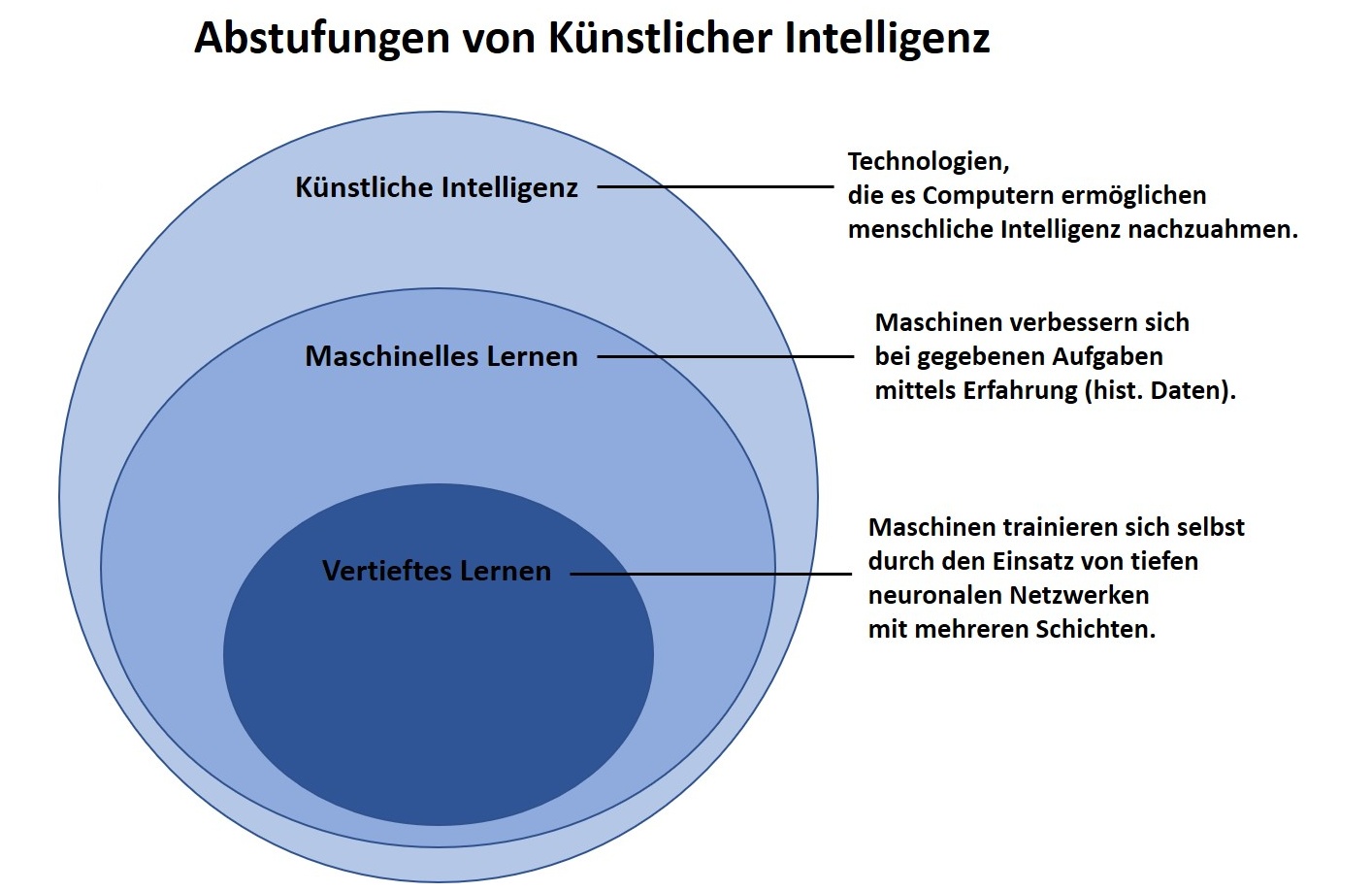

Quelle: https://www.aisoma.de/wp-content/uploads/2019/02/KI_Abstufungen.jpg

Künstliche Intelligenz

Künstliche Intelligenz (KI) – engl.: „Artificial Intelligence“ (AI) – ist ein Teilgebiet der Informatik, das den Mechanismus des intelligenten menschlichen Verhaltens modelliert. Dieser Ansatz wird durch Simulation mit Hilfe von künstlichen Artefakten erreicht, typischerweise mit Computerprogrammen auf einer Maschine, die Berechnungen durchführt. Es ist zu beachten, dass die Maschine keine elektronische Maschine sein muss.

artificial: made by people, often as a copy of something natural

aus: Cambridge Dictionary

Der Begriff „Künstliche Intelligenz“ selbst wurde von dem amerikanischen Informatiker John McCarthy erfunden und im Titel einer Konferenz verwendet, die im Jahr 1956 am Dartmonth College in Hanover, New Hampshire, USA stattfand. Sie gilt seither als die Geburtsstunde der Künstlichen Intelligenz als akademisches Fachgebiet.

Das Dartmouth Summer Research Project on Artificial Intelligence war ein Forschungsprojekt, stand unter der Leitung von John McCarthy, Marvin Minsky, Nathaniel Rochester und Claude Shannon.

Eine allgemeingültige bzw. von allen Akteuren konsistent genutzte Definition von KI gibt es bis heute nicht. Allgemein anerkannt ist, dass sich KI-Forschung zwei Feldern zuordnen lässt: der „schwachen“ und der „starken“ KI. Die „starke“ KI formuliert, dass KI-Systeme die gleichen intellektuellen Fertigkeiten wie der Mensch haben oder ihn darin sogar übertreffen können. Die „schwache“ KI ist fokussiert auf die Lösung konkreter Anwendungsprobleme auf Basis der Methoden aus der Mathematik und Informatik, wobei die entwickelten Systeme zur Selbstoptimierung fähig sind. Dazu werden auch Aspekte menschlicher Intelligenz nachgebildet und formal beschrieben bzw. Systeme zur Simulation und Unterstützung menschlichen Denkens konstruiert.

Durch den Einsatz von Metzhoden der KI können neue und wesentlich effektivere Wege der Datenanalyse als bisher entwickelt werden. Die Ableitung komplexer Korrelationen aus verschiedenen Eingabeparametern kann zu neuen Prognosemöglichkeiten, Genauigkeiten und Erkenntnissen führen. Der gewohnte Blick auf umfangreiches, raum-zeitabhängiges Datenmaterial wird direkt in das Informationssystem verlagert und damit für die eigentliche Fragestellung in ihrem technischen und raum-zeitlichen Kontext geöffnet.

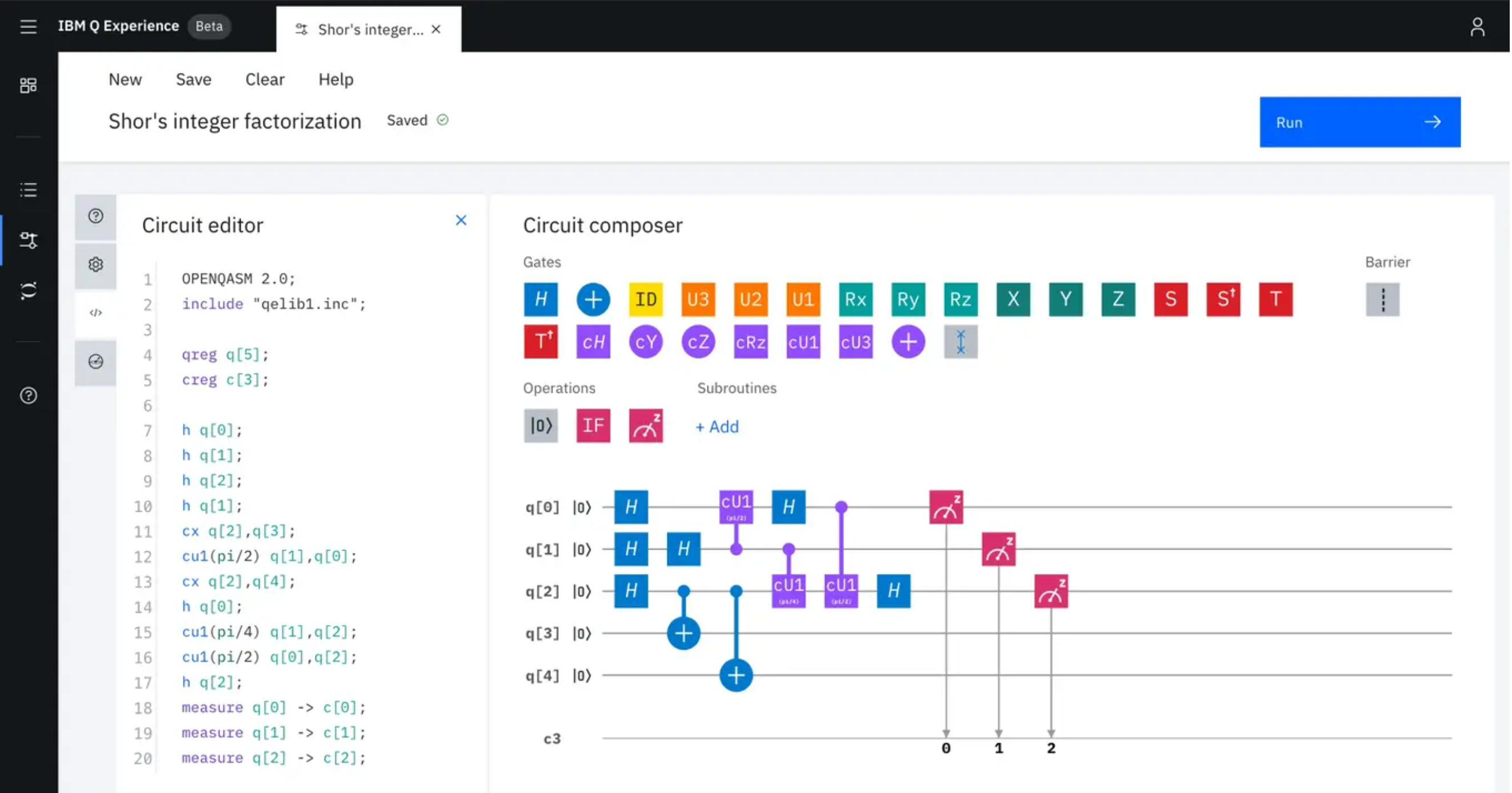

Quantum Computing

Quantencomputer nutzen die Gesetze der Quantenmechanik um die technologischen Grenzen klassischer Berechnungsmethoden zu entgehen

Weitere Infos

Quelle: https://www.ibm.com/quantum-computing/

Um Machine Learning auf verfügbaren Quantenprozessoren umzusetzen, müss diese Lösungen sowohl einen Quanten- als auch einen

klassischen Prozessor in Verbindung zu setzen, wobei nur eine minimale Anzahl von Operationen auf dem Quantenprozessor realisiert wird. In diesem hybriden Framework besteht die Verwendung des Quantenprozessors darin, einen bestimmten Quantenzustand vorzubereiten, der durch einen Satz von Variationsparametern parametriert wird. Man extrahiert dann aus diesem Zustand eine Schätzung der objektiven Funktion durch wiederholte Messungen.